电影导演Solomon W. Jagwe是Sowl工作室的联合创始人,也是《Nkoza and Nankya历险记》的创作者和导演,他展示了如何使用Charactor Creater、 iClone以及Omniverse Audio2Face。

挑战

作为一名3D动画故事讲述者和电影制作人,从表演演员那里获得令人信服的表演的过程中最具挑战性的一个方面是,必须确保嘴唇同步做得很好,并且配乐与嘴唇运动相匹配,以便观众不会分心,而是专注于故事。现在,如果你是一个预算有限的独立电影制作人,有一个小的动画团队,这个挑战会成倍增加,因为你必须在有限的资源、时间和资金下工作。这意味着你必须不断寻找能有效完成面部动画任务的方法。

当NVIDIA Omniverse和iClone合作创建了一个解决方案,使独立电影制作人的面部动画工作流程更加高效时,我知道我已经找到了一个将我脑海中的故事带入生活的解决方案。

最后的结果

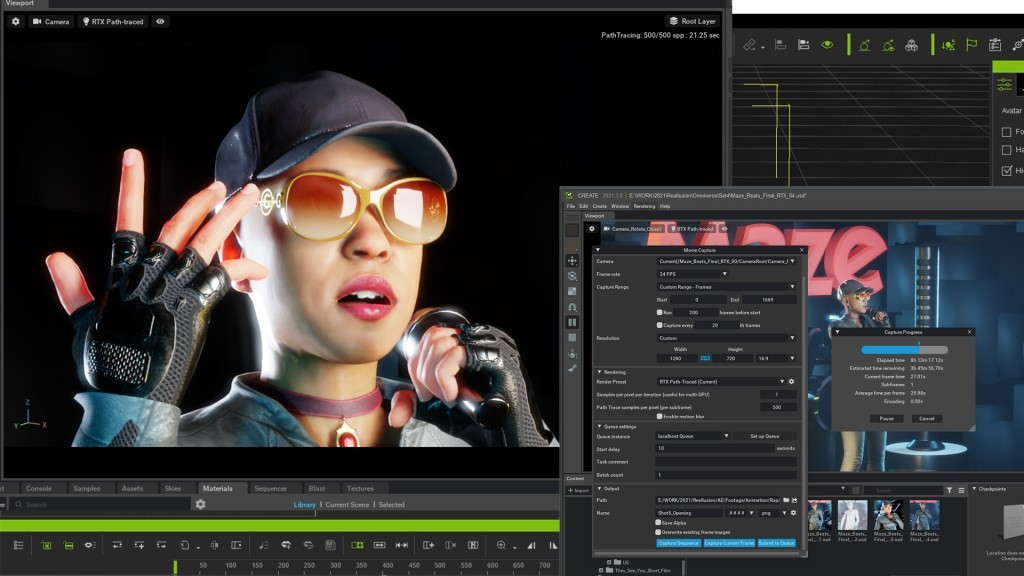

您可以查看音乐视频显示成功的结果。下面是我制作Maze BeatZ说唱音乐视频的工作流程,使用Audio2Face制作面部动画,使用Perception Neuron Studio套装,在iClone中提炼面部和身体动画,并使用路径跟踪在Omniverse中渲染最终动画。

我是如何创作这首歌的

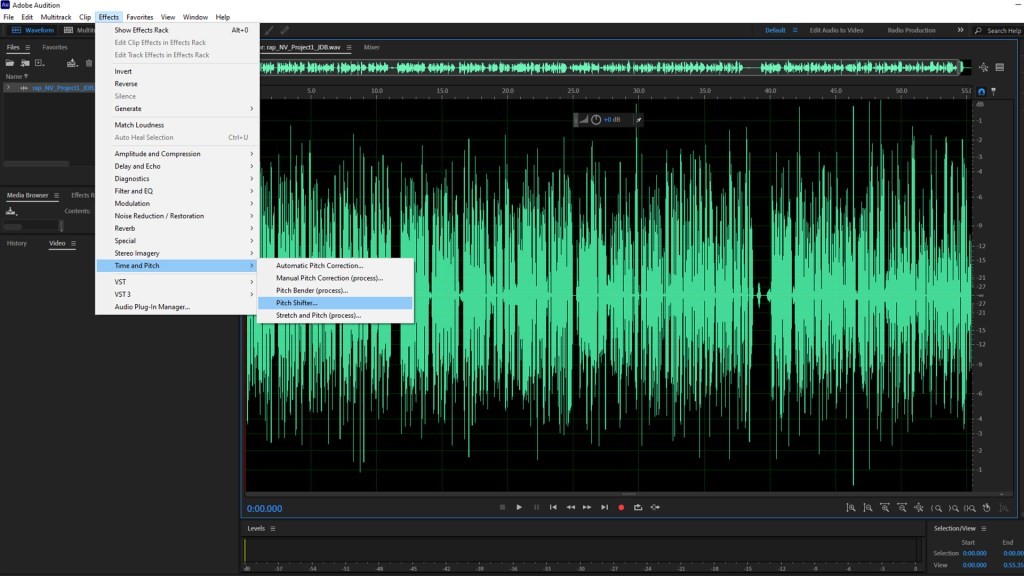

我制作Maze BeatZ视频的第一步,是想出一首说唱歌曲。我不是一个说唱歌手,但谢天谢地,已经有一个说唱曲目附带了Audio2Face。我作为起点使用的那个标注为rap_NV_Project1_JDB.wav,可以在音频播放器选项卡wave source下找到。我面临的首要问题是,我需要我的说唱明星是一位女艺术家,然而说唱曲目是男性的声音。一个快速的解决方案是去一趟Adobe Audition,并对rap轨道应用音高变换,瞧!我有我的女性说唱歌手的声音。

我制作梅兹·比茨视频的第一步,是想出一首说唱歌曲。我不是一个说唱歌手,但谢天谢地,已经有一个说唱曲目附带了Audio2Face。我作为起点使用的那个标注为rap_NV_Project1_JDB.wav,可以在音频播放器选项卡wave source下找到。我面临的最初问题是,我需要我的说唱明星是一位女艺术家,然而说唱曲目是男性的声音。一个快速的解决方案是去一趟Adobe Audition,并对rap轨道应用音高变换,瞧!我有我的女性说唱歌手的声音。

我需要添加的另一个方面是空说唱歌曲的说唱节拍。所以我和一位年轻且非常有才华的乌干达艺术家合作,我在YouTube上做音乐研究时偶然发现了他的美妙音乐。他的名字叫安德雷亚•巴古马。歌曲创作完成后,我的注意力转向了让我的女说唱歌手活起来。

我是如何创造女性说唱艺术家的

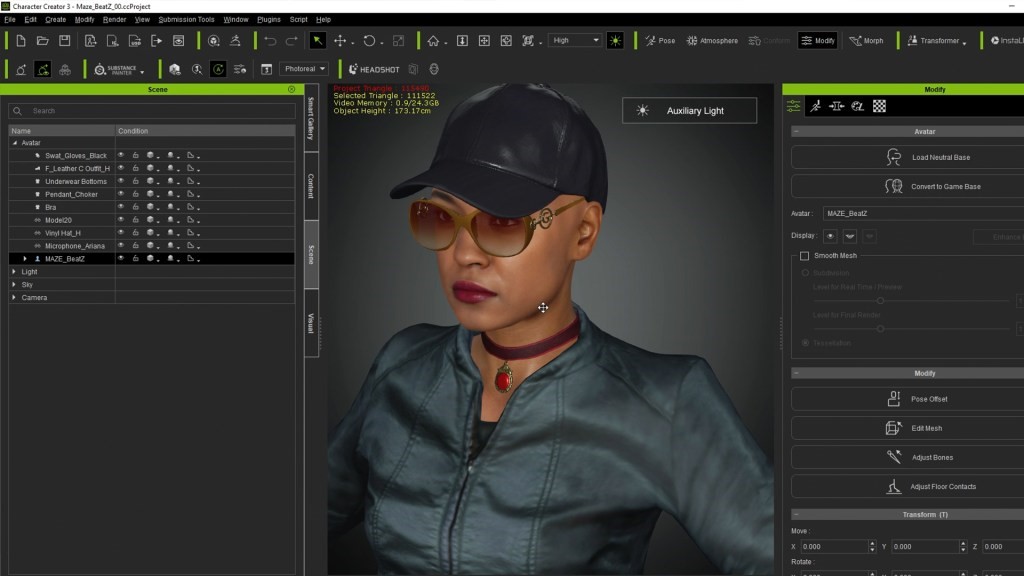

作为角色身体的开始,我使用了艾丽夏,因为我需要一个中年的非洲中心人物。我还确保使用角色的导出版本,因为我需要将完成的模型发送到Omniverse进行渲染。

我希望我的说唱明星有一套很酷的说唱服装,所以我选择了皮革服装。再次使用导出版本,如果您需要导出您的角色以便在Character Creator或iClone之外使用,强烈建议您使用导出版本。

为了给我的说唱明星配一套酷酷的服装,我挑选了一些看起来很真实的眼镜和一顶漂亮的帽子。我停留在现实世界,因为我需要角色在Omniverse中呈现时看起来很棒。

我使用Character Creator组装模型,并为iClone之旅做准备,我可以使用Motion Live和Perception Neuron Studio套装来进行身体动作捕捉,还可以让说唱艺术家准备使用Audio2Face进行面部动画创作。

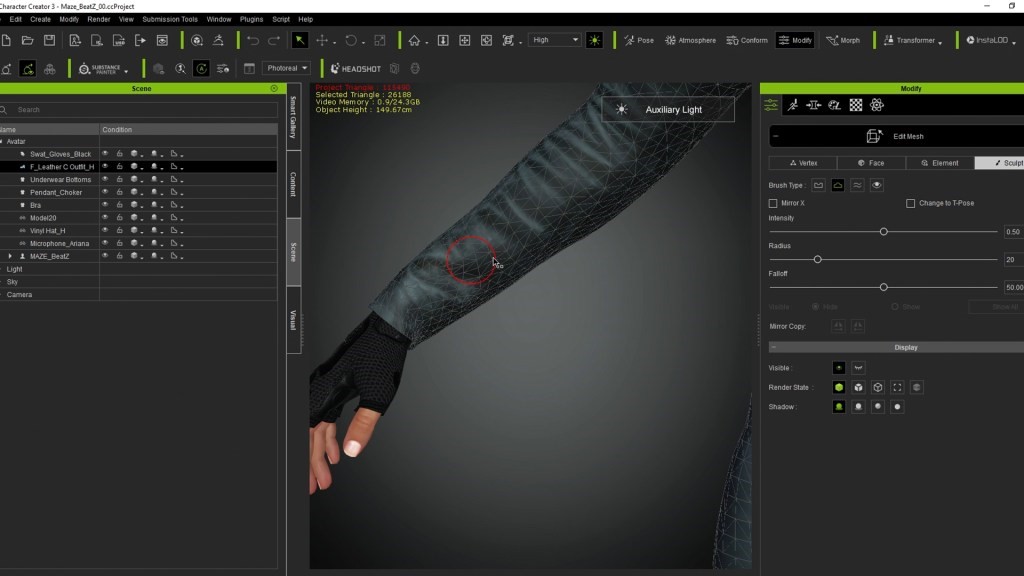

我非常喜欢在Character Creator中工作,因为你可以通过多种方式微调你的角色来创造独特的效果。Character Creator中的smart gallery插件使得导入您购买的所有物品变得非常容易,并且可以将它们应用到Character Creator中的模型中。我能够使用变形和雕刻工具进一步完善我的模型。

当我在Character Creator中完善了我的说唱艺术家之后,我将这个角色作为一个iAvatar导出到iClone。你可以把模型作为一个USD文件直接从Character Creator发送到Audio2Face,但是我需要先到iClone一次,因为那里是我制作身体和面部动画的地方。

我如何给说唱艺术家的脸和身体做动画

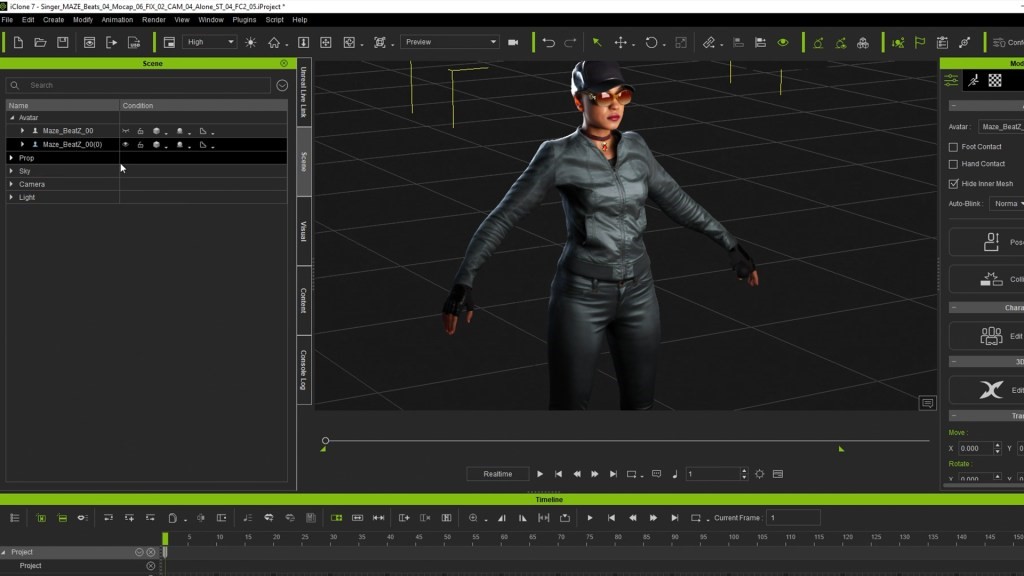

为了让我的模型为动画做好准备,我将从Character Creator导出的iAvatar角色加载到iClone,并设置了一些初始灯光,还从Daz Studio导入了一个舞台,说唱艺术家将在那里表演。

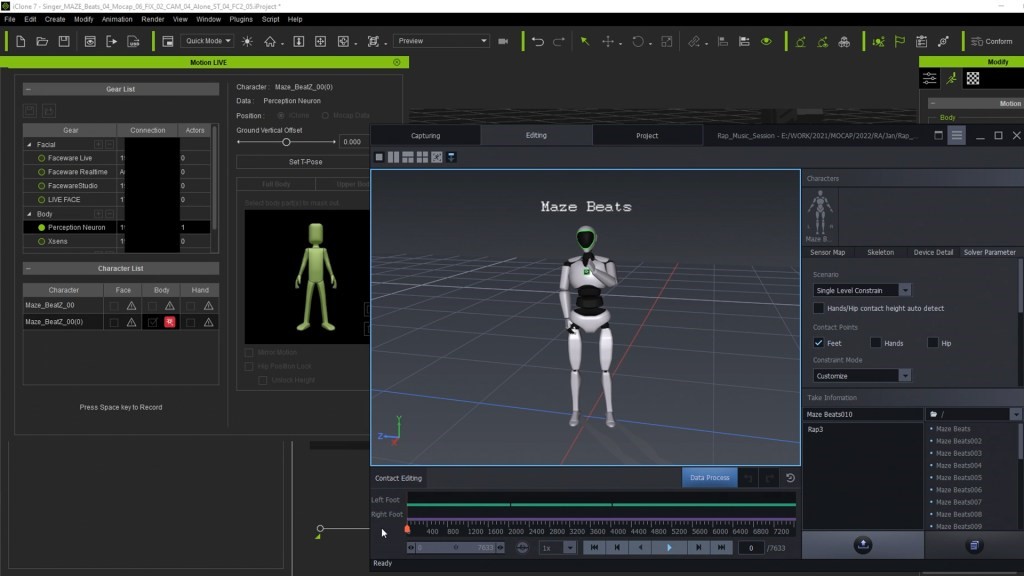

关于Character Creator角色很酷的一点是,它们完全可以在iClone中制作面部和身体动画。Reallusion在Motion Live平台中提供了几个真正强大的插件,扩展了iClone的动画功能。我非常依赖进行身体动作捕捉的Perception Neuron Studio。

我使用了Perception Neuron Studio套装来捕捉说唱艺术家的舞蹈序列。我15岁的女儿自愿扮演这个角色。在录制了她的说唱表演后,我将来自Perception Neuron Suit会话的iClone mocap文件保存到Motion文件夹中,以便在Audio2Face中创建面部mocap后,我可以重新调整它们的用途并将其应用到我的iAvatar。

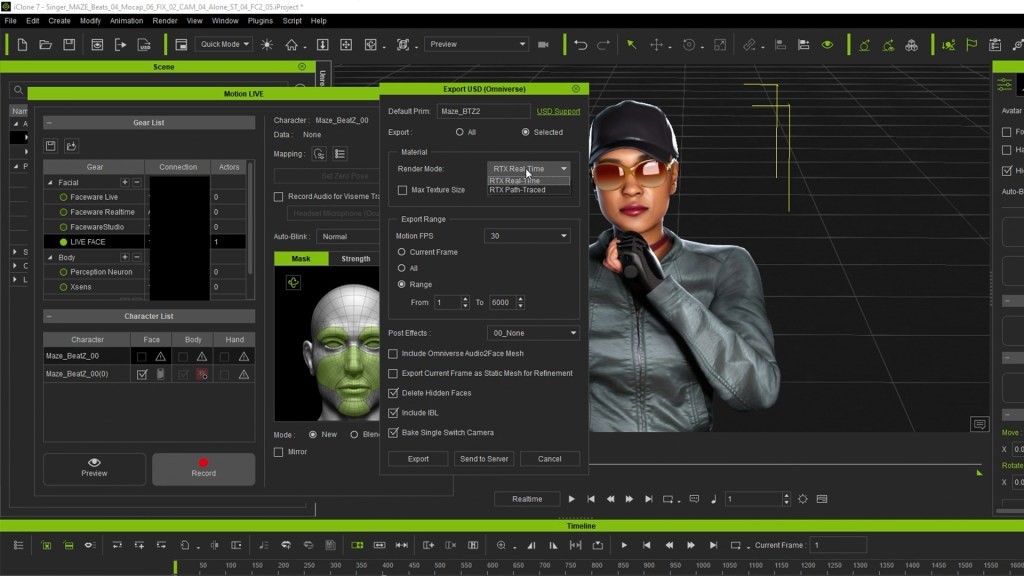

一旦我完成了基本身体动捕,我就把我的角色作为USD文件从iClone导出到Audio2Face。我确保选中了“导出USD”对话框中的“包括Omniverse Audio2Face Mesh”复选框。这一步极其重要,因为它为Audio2Face提供了识别角色面部的能力,所以你可以使用人工智能从音频文件中创建面部捕捉。我还确保选择渲染模式。我选择将RTX和路径跟踪渲染模式导出为我的角色的两个独立版本,这样我就可以选择实时预览动画以及使用Omniverse中的路径跟踪器渲染角色。

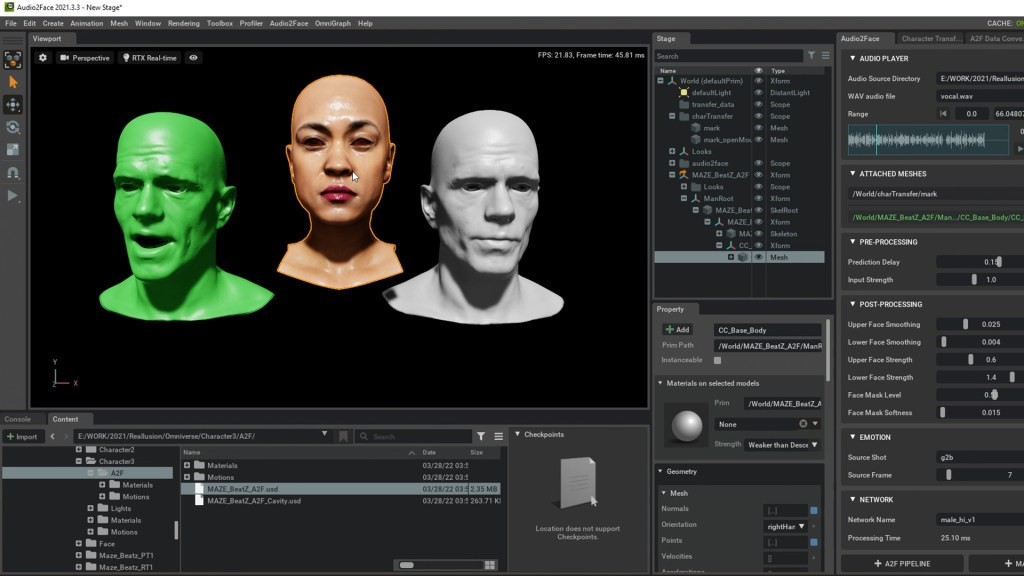

我将我的说唱艺术家角色导入Audio2Face,并开始使用内置AI传输面部动作捕捉数据的过程,这些数据来自我在该工作流程的早期步骤中提到的说唱声音轨。

Audio2Face突显步骤

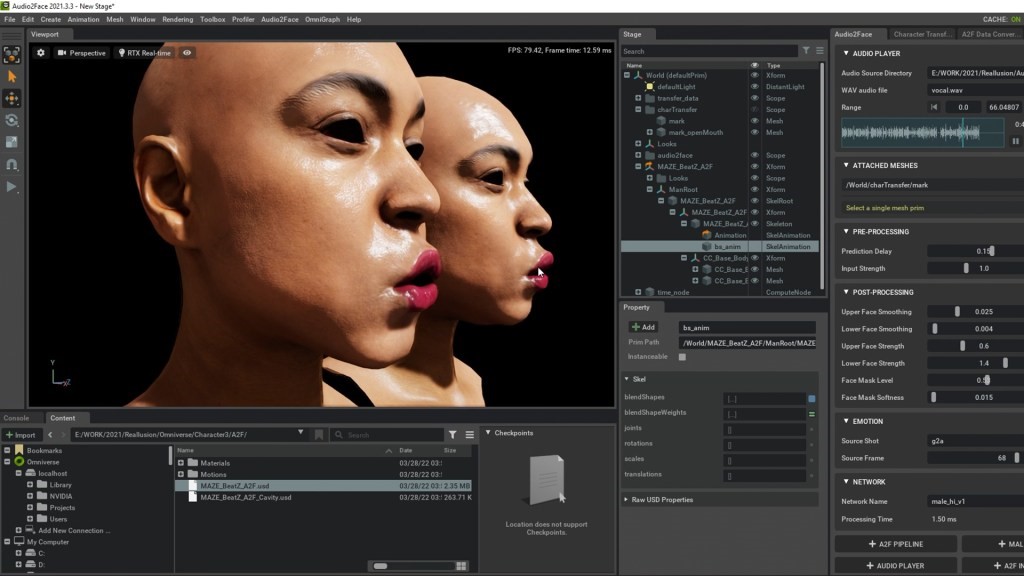

Audio2Face能够很好地使用我的女说唱歌手的声音来创作对口型,这让我大吃一惊!Audio2Face还在情感选项卡下提供了几个强大的工具,使得在ai将音频文件中的数据应用到角色头部后,可以添加细微的嘴唇运动。

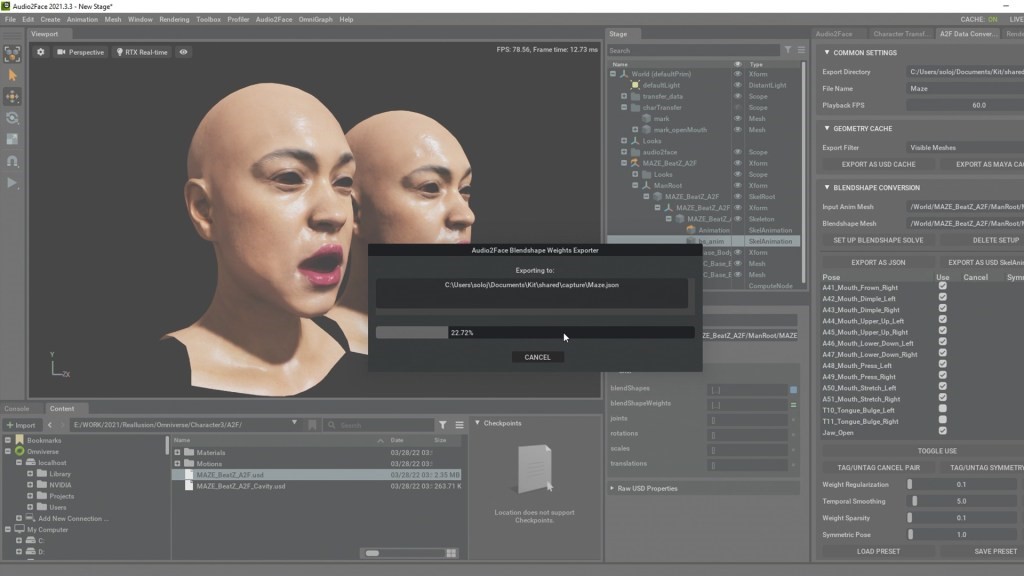

在Audio2Face中将面部动捕应用到我的角色的头部后,我将数据导出为json文件,只显示了面部的下半部分。

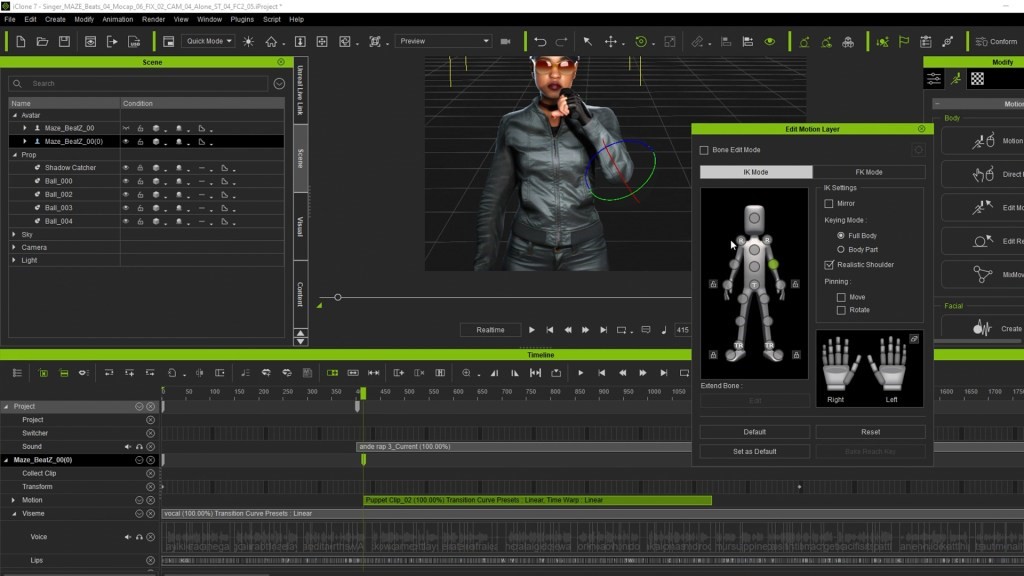

我从Audio2Face将带有下部面部动画的json文件导入到iClone中,并使用Omniverse插件将其应用于说唱艺术家角色。

Audio2Face在捕捉音轨中声音的细微差别方面做得非常好,但至少在撰写本文时,它无法捕捉到舌头的运动和眼睛的表情,这是创建令人信服的面部表演所需要的。我相信Audio2Face的未来版本已经有了解决方案,但对于我的视频,我转向了iClone内部令人惊叹的动画工具来添加那些急需的面部动画细节。

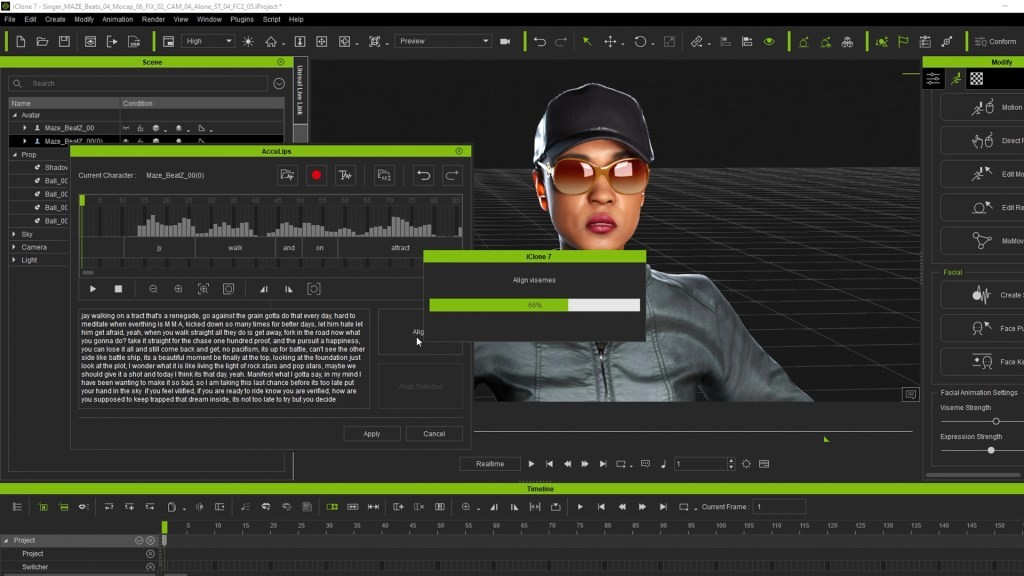

其中一个很棒的工具叫做AccuLips。我能够利用AccuLips的文本到语音功能来创建一个额外的面部动画层,其中包括舌头的运动。

我可以通过嘴唇选项进一步完善嘴唇同步,这使我能够访问各个视位,以修复任何需要改进的嘴部运动区域。

面部动画的最后一步是添加一些闪烁和更多的自定义上脸,面部动画给我的说唱艺术家一些个性。我用iPhone X拍下了自己和说唱歌手一起表演的画面。为了从iPhone X中捕捉数据,我使用了iClone内部Motion LIVE中的Live Face插件以及Reallusion的Live Face iOS应用程序。

我还能够使用iClone动作捕捉编辑动画工具来调整Perception Neuron数据。我加载了我从与女儿的对话中保存的动捕数据文件,并将其应用于我的角色。iClone使得从Perception Neuron Studio编辑动捕数据变得更加容易,该动作是使用Noitom的Axis Studio捕获的。

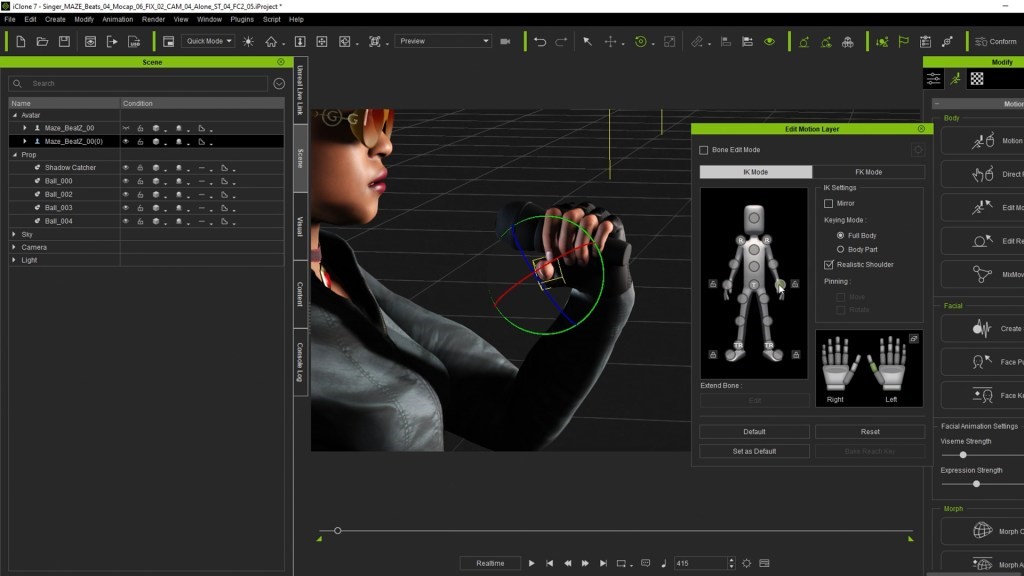

使用运动层编辑工具,我能够固定角色的手指,并添加她在最终视频中使用的麦克风的抓取。

我是如何在Omniverse中设置和渲染最终视频的

一旦我对面部动画和全身动画都满意了,我就选择了我的说唱艺术家角色,并将她作为USD文件从iClone导出到Omniverse。我导出了两个版本,一个用于RTX,另一个用于路径跟踪。这样做让我可以灵活地选择在Omniverse中是使用路径跟踪还是实时渲染。

导出为路径跟踪的优点是为Omniverse提供了一个角色,该角色具有支持次表面散射(SSS)的漂亮皮肤着色器。Character Creater模型配备了一个漂亮的皮肤着色器,在Omniverse中使用路径跟踪渲染时看起来很棒,但与RTX版本相比,它们也需要更长的时间来渲染。

我将我的说唱艺术家加载到我准备的场景中,这个场景是我从Daz Studio导出的FBX,并加载到iClone中。我使用iClone来设置试镜舞台,并将角色放置在焦点区域,然后我使用它来设置不同的相机,我知道一旦我到达Omniverse,我将需要渲染这些相机。Omniverse支持来自iClone的所有灯光和摄像机动画,这真是太棒了。

我在Omniverse内部设置了一些额外的灯光,让舞台变得栩栩如生,并增加了摄像机的移动。为了在渲染之前预览动画,我将Omniverse中的显示设置为实时,这使得迭代和调整相机和灯光变得非常容易。

我使用路径追踪渲染了最终的动画。在Omniverse中,拥有一个好的GPU对加快渲染速度大有帮助。我还使用了内置的denoiser来帮助加速渲染。

为了渲染,我使用了普吉特系统团队的定制机器,它有一个英伟达RTX 3090。这对于扭转最终的音乐视频产生了巨大的影响。以2K渲染会占用很多空间,所以我建议使用一个有足够空间的外部SSD驱动器,特别是如果你最终得到的音频文件超过2分钟。

最后的想法

我强烈推荐Omniverse,Audio2Face,Charactor Creater和iClone组合式解决方案是你讲故事过程中的面部动画工作流程,我相信它们会给你的项目带来巨大的变化。所以,去吧,给他们一个尝试。

NVIDIA提供Omniverse和Audio2Face免费下载。Realluson还提供免费下载的Omniverse iClone连接器,您可以在Omniverse启动器中找到它。Reallusion提供iClone和Character Creator版本供您在决定购买前试用。如果你没有动作捕捉套装或者没有自己的角色创建器,你可以使用来自ActorCore3D人物和mocap动画库。

用户评论 (0)